La Funzione di Attivazione nelle Reti Neurali: Il Segreto della Potenza dei Neural Networks

Le funzioni di attivazione sono un componente essenziale delle reti neurali artificiali, che rivestono un ruolo cruciale nel determinare l’output di un neurone. Queste funzioni sono fondamentali per l’apprendimento e la capacità di adattamento delle reti neurali, in quanto consentono ai neuroni di calcolare l’output in base a uno o più input. Nel corso degli anni, sono state sviluppate diverse funzioni di attivazione, ognuna con proprietà specifiche che le rendono adatte a diverse situazioni e problemi. Questo articolo offre un’analisi dettagliata sulle diverse funzioni di attivazione utilizzate nelle reti neurali, illustrando le loro caratteristiche, vantaggi e svantaggi, e fornendo esempi pratici di applicazioni.

- 1) Le funzioni di attivazione sono fondamentali nelle reti neurali perché permettono di introdurre non linearità nei calcoli effettuati dai neuroni artificiali. Questa non linearità è necessaria per affrontare problemi complessi e per consentire alle reti neurali di apprendere pattern più sofisticati.

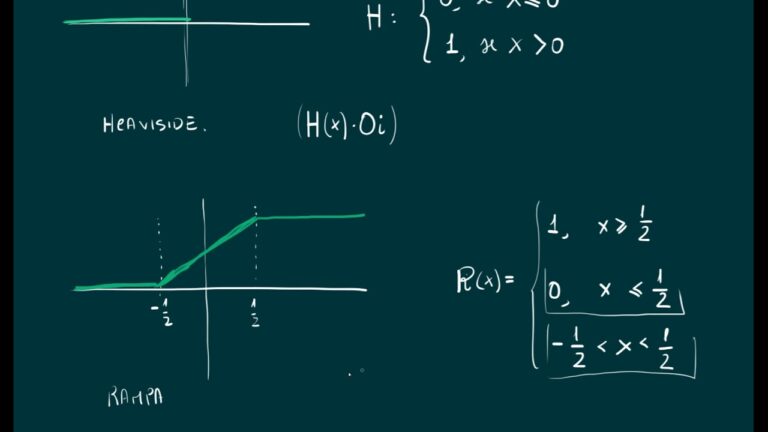

- 2) Le funzioni di attivazione possono avere diverse forme e caratteristiche. Alcune delle funzioni di attivazione più comuni sono la funzione sigmoide, la funzione ReLU (Rectified Linear Unit) e la funzione softmax. Ognuna di queste funzioni ha diverse proprietà e può essere utilizzata in diversi contesti a seconda delle specifiche esigenze del modello di rete neurale.

Vantaggi

- 1) Maggiore flessibilità: le funzioni di attivazione nelle reti neurali consentono di modellare e adattare i dati in modo più flessibile rispetto ad altre tecniche di apprendimento automatico. Ciò permette di adattare meglio la rete ai dati e alle caratteristiche specifiche del problema da risolvere.

- 2) Maggiore capacità di apprendimento: le funzioni di attivazione nelle reti neurali possono fornire una capacità di apprendimento migliore rispetto ad altre tecniche. Alcune funzioni di attivazione, come ad esempio la funzione ReLU, sono in grado di apprendere più rapidamente e consentono una migliore propagazione dei segnali all’interno della rete.

- 3) Persistenza della memoria: alcune funzioni di attivazione, come la funzione LSTM (Long Short-Term Memory), consentono di mantenere la memoria delle informazioni passate. Questa capacità di persistenza della memoria può essere molto utile in problemi di sequenza, come la modellazione del linguaggio o la previsione delle serie storiche.

- 4) Non linearità: le funzioni di attivazione introducono non linearità nel modello, consentendo alla rete di apprendere relazioni e pattern complessi nei dati. Ciò permette alla rete di approssimare meglio la funzione di decisione sottostante e migliorare le performance di previsione o classificazione.

Svantaggi

- Overfitting: le funzioni di attivazione possono portare alla creazione di modelli neurali troppo complessi che imparano a memoria i dati di addestramento senza riuscire a generalizzare bene su nuovi dati. Questo fenomeno è conosciuto come overfitting e può ridurre significativamente le capacità predittive della rete neurale.

- Divergenza: alcune funzioni di attivazione, come ad esempio la funzione di attivazione lineare, possono causare problemi di convergenza durante l’addestramento della rete neurale. La divergenza si verifica quando i pesi della rete non vengono aggiornati in modo corretto e di conseguenza la rete non riesce a imparare dai dati forniti.

- Vanishing Gradient: alcune funzioni di attivazione, come ad esempio la funzione sigmoide, possono essere soggette al problema del gradientevanishing. Questo accade quando i valori dei gradienti calcolati durante la retropropagazione dell’errore diventano via via più piccoli man mano che ci si avvicina a strati più vicini all’input della rete. Di conseguenza, le connessioni tra questi strati ricevono aggiornamenti di peso molto piccoli, rendendo difficile l’apprendimento efficiente.

- Tendenza all’attivazione saturata: alcune funzioni di attivazione, come ad esempio la funzione sigmoide, mostrano una tendenza ad saturarsi se i valori di input sono troppo grandi o troppo piccoli. Ciò significa che l’output dell’attivazione non cambierà molto anche se i valori di input variano notevolmente. Questo può portare a una perdita di informazioni durante la propagazione all’interno della rete e alla riduzione delle capacità predittive complessive.

Qual è l’utilità della funzione di attivazione?

La funzione di attivazione è un elemento fondamentale delle reti neurali in quanto permette di introdurre la non linearità nell’elaborazione dei dati. Essa è vitale per modellare le complesse relazioni tra gli input e gli output di una rete neurale. La sua utilità principale consiste nel poter apprendere e adattarsi a modelli di dati complessi, rendendo la rete in grado di approssimare e generalizzare i pattern desiderati. Senza la funzione di attivazione, una rete neurale sarebbe limitata a esprimere solamente relazioni lineari, compromettendo quindi la capacità di apprendimento e l’efficacia del modello.

La funzione di attivazione è fondamentale nelle reti neurali poiché permette di introdurre la non linearità nell’elaborazione dei dati. Questo è essenziale per modellare relazioni complesse tra input e output, consentendo alla rete di apprendere e adattarsi a modelli di dati complessi. Senza la funzione di attivazione, la rete sarebbe limitata a esprimere solo relazioni lineari, compromettendo l’efficacia dell’apprendimento.

Qual è il funzionamento delle reti neurali?

Le reti neurali funzionano attraverso un processo di assegnazione dei pesi ai livelli di input. Questi pesi determinano l’importanza delle variabili all’interno della rete, con quelli più grandi che influiscono maggiormente sull’output rispetto agli altri input. In questo modo, le reti neurali sono in grado di elaborare e analizzare dati complessi per fornire risultati significativi. Questo meccanismo è alla base del funzionamento delle reti neurali, consentendo loro di apprendere e adattarsi alle nuove informazioni.

Le reti neurali lavorano assegnando pesi ai livelli di input, determinando l’importanza delle variabili nella rete. I pesi più grandi influenzano maggiormente l’output, consentendo alle reti neurali di elaborare dati complessi e adattarsi alle nuove informazioni.

Quali sono le tre reti neurali?

Le tre reti neurali principali sono il tipo supervisionato, il tipo non supervisionato e il tipo di apprendimento per rinforzo. Nel caso della rete neurale supervisionata, viene fornito un insieme di dati di addestramento etichettati che la rete utilizza per imparare a fare previsioni o classificazioni. Nella rete neurale non supervisionata, invece, la rete impara a riconoscere schemi e strutture nascoste nei dati senza l’ausilio di etichette o input guidati. Infine, nella rete neurale di apprendimento per rinforzo, la rete apprende attraverso l’interazione con un ambiente, ricevendo feedback sotto forma di ricompense o penalità per le sue azioni.

Esistono tre tipi di reti neurali principali: supervisionato, non supervisionato e di apprendimento per rinforzo. Il tipo supervisionato utilizza un insieme di dati etichettati per imparare a fare previsioni o classificazioni. Il tipo non supervisionato riconosce schemi e strutture nascoste nei dati senza etichette o input guidati. Infine, il tipo di apprendimento per rinforzo apprende attraverso l’interazione con l’ambiente, ricevendo feedback di ricompense o penalità per le sue azioni.

Un’analisi approfondita delle funzioni di attivazione nelle reti neurali: Scoperte recenti e potenziali applicazioni

Nell’ambito delle reti neurali, le funzioni di attivazione svolgono un ruolo fondamentale nella trasmissione e nell’elaborazione dei dati. Recentemente, sono state compiute importanti scoperte riguardanti l’efficacia di diverse funzioni di attivazione nel migliorare la precisione e la stabilità delle reti neurali. Inoltre, queste scoperte hanno aperto la strada a potenziali applicazioni rivoluzionarie nelle aree della visione artificiale, del riconoscimento del linguaggio naturale e dell’elaborazione dei segnali. L’analisi approfondita delle funzioni di attivazione continua a svolgere un ruolo cruciale nello sviluppo di reti neurali più efficienti e performanti.

Una recente scoperta nell’ambito delle reti neurali ha dimostrato l’importanza delle funzioni di attivazione per migliorare la precisione e la stabilità delle reti. Ciò ha aperto nuove possibilità di applicazioni rivoluzionarie nella visione artificiale, nel riconoscimento del linguaggio naturale e nell’elaborazione dei segnali. L’analisi delle funzioni di attivazione continua a essere cruciale per sviluppare reti neurali più efficienti.

Esplorando le diverse funzioni di attivazione per ottimizzare le reti neurali: Un’indagine comparativa

Nell’ambito dell’ottimizzazione delle reti neurali, una sfida fondamentale risiede nella scelta della funzione di attivazione più adatta. Questo articolo si propone di condurre un’indagine comparativa sulle diverse funzioni di attivazione disponibili al fine di determinare quale sia la più efficace per ottimizzare le prestazioni delle reti neurali. Saranno analizzate funzioni come sigmoid, ReLU, tanh e Leaky ReLU, valutando i loro vantaggi e svantaggi in termini di velocità di convergenza e stabilità dell’addestramento. I risultati di questa indagine potrebbero fornire indicazioni preziose per sviluppare reti neurali ancora più performanti e efficienti.

Aggiungere nuove funzioni di attivazione potrebbe essere la soluzione per migliorare l’ottimizzazione delle reti neurali. Attraverso un’indagine comparativa, verranno analizzati vantaggi e svantaggi di queste nuove funzioni, al fine di sviluppare reti neurali ancora più performanti e stabili.

Le funzioni di attivazione sono elementi fondamentali nella progettazione e nell’efficacia delle reti neurali. Queste funzioni permettono di introdurre la non-linearità nel sistema, consentendo alle reti neurali di imparare modelli più complessi e di adattarsi ai dati di input in modo ottimale. La corretta scelta della funzione di attivazione dipende dal tipo di problema che si desidera risolvere, considerando fattori come la natura dei dati, la complessità del modello e l’obiettivo desiderato. Le funzioni di attivazione più comuni includono la funzione sigmoide, la funzione ReLU e la funzione tangente iperbolica, ognuna con i suoi vantaggi e limitazioni. È importante comprendere il ruolo delle funzioni di attivazione per sfruttare appieno le potenzialità delle reti neurali e ottenere risultati di alta qualità in molteplici ambiti come il riconoscimento di immagini, la traduzione automatica e l’elaborazione del linguaggio naturale.